はじめに

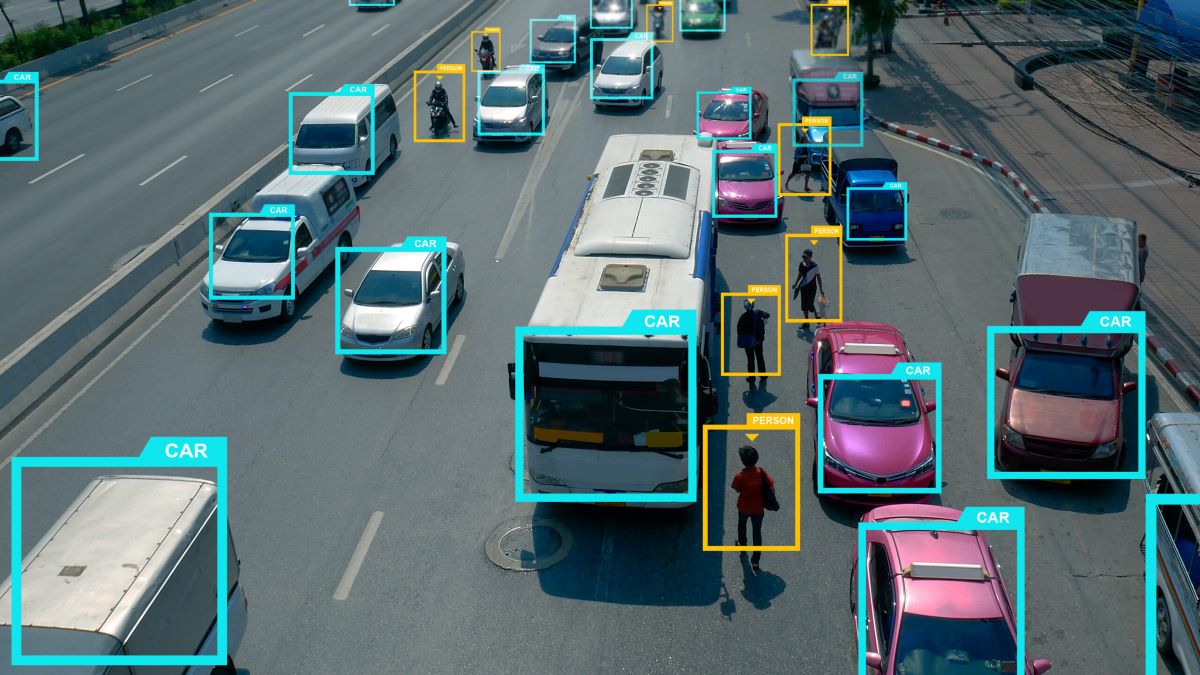

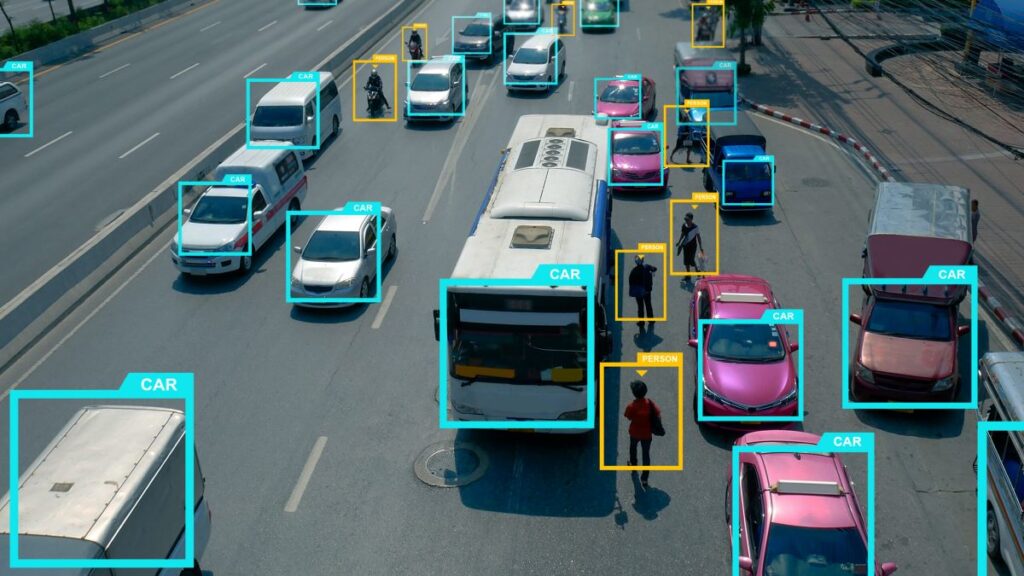

AIは、私たちの身の回りのさまざまなシステムで活用されています。例えば、最近の自動車にはAIを用いた運転支援システムが搭載されています。自動車に搭載されたカメラで周囲の画像を撮影することで、撮影された画像の中からAIが標識を見つけ出し、ドライバーにアイコンを表示して知らせる機能があります。このように、AIは私たちの生活を支援する機能として実際に活用されています。

敵対的サンプルとは?

敵対的サンプルとは、AIシステムが正常に機能しなくなるように設計されたデータのことです。例えば、標識を認識する画像認識AIに対して、「一時停止」の標識を正しく認識するのを妨げるために、わずかなランダムなノイズを加えることがあります。あるいは、小さな文字やイラストを加える細工も考えられます。こうした画像への細工は人間の目には見えないか人間には不自然に見えないものです。しかし、AIにとっては大きな混乱をもたらし、その結果誤った出力を引き起こすことがあります。

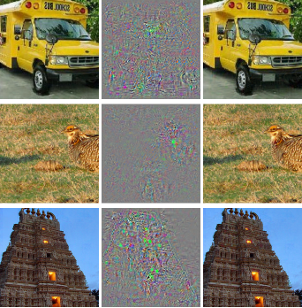

図1: C. Szegedy et al., “Intriguing properties of neural networks” [1] (CC-BY)

具体的な例を図1に示します。図1のうち、左の列3枚の画像は元の画像、中心の列3枚は元の画像に加えるノイズを10倍に強調したもの、右の列3枚はノイズが加えられた画像です。左の列と右の列を見比べると、人間にとってはほとんど差が分かりません。しかし、それぞれの画像がAIに入力されると、右の列の画像に対しては誤った識別結果を出力するのです。

どのような敵対的サンプルがあるのか?

私たちの身の回りのさまざまなシステムでAIが使われています。そうしたAIに対して敵対的サンプルが入力されると、私たちの生活に影響を及ぼすかもしれません。以下では、敵対的サンプルの例を挙げます。

・画像認識システムに対する敵対的サンプル

画像にノイズやパッチ(特殊な模様)を加えることで、敵対的サンプルを作成します。人が見ても分かりにくいように、ごくわずかなノイズを加えたり、自然に見えるパッチを加えたりします。

・音声認識システムに対する敵対的サンプル

人間には聞き分けられないほどのわずかな音声ノイズを加えることで、敵対的サンプルを作成します。

・言語モデルに対する敵対的サンプル

例えば感情分析AIでは、入力された会話にもとづいて、話者の感情を推定することができます。このようなAIに対しては、例えば文章中の単語を同じ意味の別の単語や表現に置き換えることで、敵対的サンプルを作成します。

・そのほかのモデルに対する敵対的サンプル

他にも、さまざまなAIに対する敵対的サンプルが考えられています。例えば、マルウェアを検知するAIに対して、マルウェアでないと判断させるような敵対的サンプルを作成できる事例が、論文レベルで報告されています[2]。

このように、敵対的サンプルにはさまざまなものが考えられます。共通する性質としては、元の情報に変更を加えることでAIの判断を誤らせる点と、その変更がごくわずかなためにAIの利用者が気づきにくい点にあります。そのため、敵対的サンプルに対する技術的な対策の研究が進められています。

どのように対策が取られているのか?

敵対的サンプルの脅威が初めて指摘されたのは、2013年ごろです。それ以来、研究者たちはさまざまな対策技術を考え、提案しています。以下に、その代表例を示します[3]。

・敵対的学習

AIを学習する途中で敵対的サンプルを生成し、訓練データに含めることで、敵対的サンプルに対する耐性を持たせます。

・敵対的サンプルの検知

敵対的サンプルはAIの判断を誤らせることから、そのデータとしての性質が通常のものと異なると考えることができます。その点に着目して、異常なデータを検出する方法も提案されています。

・モデルの蒸留

敵対的サンプルは、AIが訓練データに特化しすぎる過学習と呼ばれる現象が一因であると言われています。そのため、AIが判断するために入力データの本質部分を学習する、蒸留と呼ばれる技術が応用できます。

・入力データの修正

入力データを修正することで、敵対的サンプルの影響を緩和することができます。例えば、ノイズを加えることで作成された敵対的サンプルに対しては、高周波成分を除去するノイズフィルタを適用することで、AIへの影響を緩和することが期待されます。

まとめ

敵対的サンプルの脅威は、AI技術の将来にとって重要な課題です。しかし、日々の研究や技術の進展によって、防御策も進化しています。私たちがAIを安全に活用するためには、こうした課題に対する理解と対策が不可欠です。今後もAI技術の発展を見守りつつ、安全性を確保するための努力が必要です。

参考文献

[1] C. Szegedy et al., “Intriguing properties of neural networks,” https://arxiv.org/abs/1312.6199

[2] K. Aryal et al., “A Survey on Adversarial Attacks for Malware Analysis,” in IEEE Access, vol. 13, pp. 428-459, 2025, doi: 10.1109/ACCESS.2024.3519524.

[3] J. Zhang and C. Li, “Adversarial Examples: Opportunities and Challenges,” in IEEE Transactions on Neural Networks and Learning Systems, vol. 31, no. 7, pp. 2578-2593, July 2020, doi: 10.1109/TNNLS.2019.2933524.

-scaled.png)