はじめに

今や、AI(人工知能)は私たちの生活のあちこちで使われています。たとえば、スマートフォンの顔認証や自動運転の自動車、オンラインストアでの商品のおすすめ表示などもそうです。でも、そんな便利なAIも「だまされてしまう」ことがあるのをご存じでしょうか?

その代表例が、「敵対的サンプル」と呼ばれる仕掛けです。この記事では、その仕組みと守り方を、できるだけわかりやすくご紹介します。

そもそも「敵対的サンプル」って何?

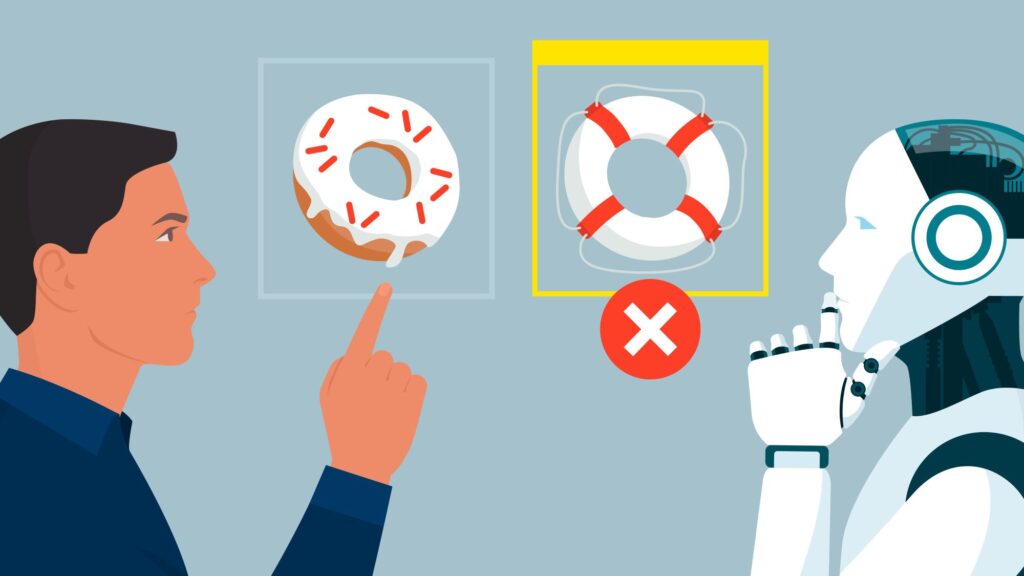

AIは、人間が見て「これはリンゴ」「これは止まれの標識」とわかる画像や、人間が聞き分けられる音声を、たくさん学んで判断する仕組みです。でも、ほんの少しだけ画像や音声などを変えることで、人間には普通に見えるのに、AIだけが間違えることがあります。これが「敵対的サンプル」です。

【例】

たとえば、道路の「止まれ」の標識に、目では気づかないくらい細かい模様を足します。すると、AIはそれを「違う標識」と勘違いしてしまうことがあります。人間には普通に見えるのに、AIだけがだまされてしまう、不思議な現象です。

AIはどうやって作られているの?

AIは、大きく分けて以下のような流れで作られます。

- データを集める・整理する

- AIを作る・学ばせる

- テストして、ちゃんと動くか確認する

- 実際に使う

この中で、「敵対的サンプル」はAIを「4. 実際に使う」ときに、特に大きな問題になります。

敵対的サンプルへの主な守り方

では、どうすればAIはだまされにくくなるのでしょうか?いくつかの方法がありますが、ここでは代表的な方法をご紹介します。

1. だまされやすい例も一緒に学ばせる(敵対的学習)

AIを作る・学ばせるときやさらに良くするときに、わざと「だまされやすいデータ」も一緒に教える方法です。そうすることで、AIは「こんな変なデータもあるんだ」と覚えて、だまされにくくなります。

2. おかしなデータを見つける仕組みをつける(検知器)

AIに入力されるデータが「いつもとちょっと違うぞ?」と感じたときに、「変なデータかも」と気づける仕組みをつける方法です。これにより、だまされる前にストップをかけることができます。

3. 特に大切な部分をAIに教えなおす(モデル蒸留)

AIが「勉強しすぎて頭でっかち」になりすぎると、ちょっとした変化にも弱くなります。なので、一度学んだことの中で特に大切な部分をもう一度やさしく教え直してあげることで、勉強した内容を整理したシンプルなAIに作り直す方法もあります。

4. 「どこまで大丈夫か」をあらかじめ決めておく(頑健性保証)

AIが、どんな細工までならだまされないかを、あらかじめ決めておく方法もあります。ただし、守る範囲を広げすぎるとAIの普段の性能が落ちてしまうこともあるので、バランスが大切です。

5. 入ってくるデータをきれいにする(データ前処理)

AIにデータを渡す前に、あらかじめノイズなどの「ゴミ」を取り除くことで、だまされにくくする方法です。ただし、やりすぎると本来のデータまで変わってしまうリスクもあります。

まとめ

AIはとてもかしこくて便利ですが、「だまされることがある」という弱点もあります。

でも、いろいろな工夫や守り方で、こうした問題を減らすことができます。

これからもAIは私たちの生活でどんどん使われていきます。

AIを安全に、安心して使うために、「だまされないための工夫」もとても大切なのです。

※ 本記事は、専門家向けの解説記事「敵対的サンプルに対する対策技術」をもとに、生成AIを活用して作成しています。生成AIの具体的な活用方法については、「生成AIを活用した一般読者向け解説記事の提供について」をご参照ください。

-scaled.png)