はじめに

本記事では、AIがどのように予測を行ったかを説明する技術である「説明可能AI(XAI)」について解説します。本記事を読むことで、XAIの概要や研究の最新動向、課題、今後の方向性について理解を深めることができます。

説明可能AI(XAI)とは?

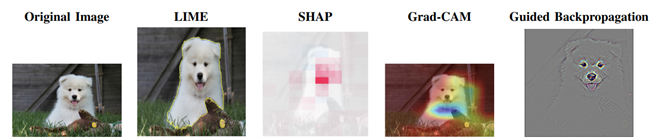

XAIは、AIモデルがどのように判断や予測を行ったのか、その根拠や理由を人間が理解できる形で説明できるAI技術や仕組みを指します。従来のAIモデル、特にディープラーニングなどの高度なモデルは「ブラックボックス」と呼ばれ、内部の判断プロセスが理解しにくいという課題がありました。XAIは、このブラックボックス性を解消し、利用者や開発者がAIの判断根拠を理解するために有用です。XAIの進展により、AIの予測結果に対する信頼性や透明性が向上するなどの利点があります。XAIによる説明の対象は、個々のデータとモデルの2種類があります[1]。個々のデータに対する説明は、そのデータに対する予測の根拠を理解するのに役立ちます。一方で、モデルに対する説明は、モデルに関する特性を理解するために有用です。このモデルに対する説明は、モデルの構造などの内部情報を利用する必要があり、複雑なモデルに対しては適用することが難しいという問題があります。しかし、内部情報がわからない複雑なモデルに対しても適用可能な手法も提案されおり、これらの手法を適用することですべてのモデルの説明を取得することが可能になっています。図1に代表的なXAI手法による説明の比較画像を示しています。XAI手法を使うことで、人間にとってもわかりやすい視覚的な説明を作成し、AIの予測結果に対する判断根拠を知ることができます。

図1:代表的なXAI手法の比較画像. (出典:Devireddy, Keerthi. “A Comparative Study of Explainable AI Methods: Model-Agnostic vs. Model-Specific Approaches.”[2], CC-BY 4.0、一部改変)

XAIの分類

研究論文[3]によると、XAIの手法は、説明性を取得する技術にもとづいて、以下の2つに分類できます。以下では、代表的な手法を説明します。

摂動を利用した手法

この種の手法では、入力に微細な変化(摂動)を加えた時のモデルの予測の変化をもとに説明を提供します。

- Local Interpretable Model-agnostic Explanations (LIME)

LIME[4]は、複雑な識別境界や内部構造を持つAIモデルであっても、説明の対象の近傍では、単純なモデルで分類を近似できることに着目した手法です。入力データxの特徴量をもとに、各特徴をランダムにマスク(削除、置換)した「擬似データ」\(x’\) を多数生成します。例えば、画像データの場合、部分的にピクセルや領域を消去するなどの処理を施します。生成した各\(x’\)に対してブラックボックスモデル\(f(x)\)で予測値を得ます。その後、各\(x’\)が元の\(x\)にどれだけ近いか(類似度)を計算し、近いデータほど高い値を与え、遠いものは低い値を割り当てます。生成したデータ\((x’,f(x))\)を使い、\(x\)の近傍での振る舞いを模倣する「単純な」説明モデル\(g\)(線形モデルや決定木など)を学習します。この\(g\)は、人間にとって理解しやすい形(特徴量の重みなど)で予測を説明するように設計されており、学習済みの\(g\)から、どの特徴量が元の予測\(f(x)\)にどの程度影響したかを寄与度として算出し、可視化を行います。モデルに依存しないため、任意のモデルに適用可能です。しかし、疑似データの生成はランダムに行われるため、説明結果が一定にならないなどの課題もあります。

- SHapley Additive exPlanations (SHAP)

SHAP[5]は、ゲーム理論の「Shapley値」に基づき、特徴量の組み合わせごとにその特徴がモデルの出力にどの程度貢献したかを計算します。特徴量の有無を変えながらモデルの出力を算出し、その差分から各特徴の寄与度を推定します。SHAPは、モデルに依存しないため、ほとんどのモデルに対して利用可能である点が特徴の一つです。しかし、複雑なモデルに対しては、近似計算を用いているため、説明性が低下する可能性があるという問題があります。

- Counterfactual Explanations (CFE)

CFE[6]は、AIモデルの予測や判断がどのように変化するかを理解するために、「もし入力データの一部が異なっていたら結果はどうなっていたか?」という仮想的なシナリオ(反事実)を生成し、その出力の違いを観察することでモデルの判断根拠を説明する手法です。CFEは、モデル非依存な手法として、多くの機械学習モデルに適用可能であり、個々のデータの予測に対する説明として有効です。出力がどう変化するかを直接的に示し、「どの特徴をどの方向に変えれば結果が変わるか」を知ることができます。しかし、反事実の生成は計算コストが高い場合があることや、モデルに対する説明には適さず、反事実生成の際のデータ分布やタスク設計に依存しやすいという特徴があります。反事実の内容によっては、倫理的な配慮が必要な場合(性別や人種を変更するなど)もあるため注意が必要とされています。

勾配を利用した手法

勾配を利用した手法では、入力の特徴に関する出力の勾配を利用することで説明を提供します。代表的な手法は以下になります。

- サリエンシーマップ(Saliency Map)

サリエンシーマップ[7]は、モデルの出力(予測値)を入力特徴ごと(画像の各ピクセルなど)に微分(勾配)し、どの特徴がモデルの予測にどれだけ影響を与えたかを可視化する手法です。勾配の絶対値が大きい特徴ほど、予測に重要であったことを示します。サリエンシーマップは、モデル非依存であるため、直感的な可視化が可能ですが、ノイズに敏感であり、複数の特徴が強調されて説明が曖昧になる場合もあるという課題があります。

- Layer-wise Relevance BackPropagation(LRP)

LRP[8]は、モデルの出力を各入力特徴に対して、関連度スコアとして逆伝播して割り振る手法です。ネットワークの各層ごとに貢献度を分配し、最終的に特徴ごとの寄与を算出します。主にニューラルネットワーク(特に画像モデル)で利用され、層ごとにリバランスしつつ説明を伝播するため、深いネットワークでも適用が可能です。LRPは、説明にバイアスが含まれにくく、正確で信頼性のある説明性を提供できます。しかし、実装と解釈がやや複雑であり、モデルの構造情報が必要です。

- Class Activation Map(CAM)

CAM[9]は、CNN(Convolutional Neural Networks)モデルの最終畳み込み層の出力(特徴マップ)と、各クラスの重みを組み合わせて、入力画像のどの領域がそのクラスの予測にどれだけ重要だったかをヒートマップとして示す手法です。特に画像分類タスクにおける分類根拠になった領域の可視化に使われ、直感的で視覚的な説明を提供できます。しかし、CAMはモデル固有であり、CNNの構造や重みに関する情報が必要です。

- Integrated Gradients(IG)

IG[10]は、基準となる入力(真っ黒な画像やゼロベクトルなど)から実際の入力までの勾配を積分することで、各特徴の重要度(寄与度)を計算する手法です。画像やテキスト、その他の深層学習モデルにも適用可能です。IGは、SensitivityとImplementation Invarianceと呼ばれる二つの公理を満たすように設計されています。Sensitivityとは、ある入力に対する出力が基準となる入力の出力と異なったとき、その入力の特徴量の寄与は非ゼロであるというものです。一方で、Implementation Invarianceは、実装方法が異なっていても、同じ入力に関する寄与度はその影響を受けず、等しいというものです。IGは、基準となる入力との差分を考慮することで、直感的かつ理論的な説明が可能な手法ですが、基準の入力の選び方や積分の設定に依存しやすい課題もあります。

トランスフォーマー(Transformer)に対する手法

近年、トランスフォーマーモデル(BERT, GPT, ViTなど)は自然言語処理や画像認識などの多様な分野で主流となっており、様々な応用が期待されています。しかし、自己注意(Self-Attention)機構などの複雑な内部構造により、判断根拠がブラックボックス化しやすいという課題があり、これを可視化・説明するためのXAI手法が近年活発に研究されています。

トランスフォーマー系モデル向けのXAI手法は、アテンション機構の可視化[11]、勾配ベースの寄与度算出[12]、プロンプトベースの推論過程説明[13][14]、反事実的入力の分析などをもとにした多角的なアプローチが発展しています。これにより、LLM(Large Language Model)などの大規模モデルの判断根拠・推論過程を可視化し、透明性・信頼性を高めることが可能になりつつあり、近年では盛んに研究が行われています。

課題と今後の方向性

AIの説明性を高めるために、XAIは日々研究が行われていますが、さまざまな課題があります。具体的には以下のようなものがあります。

- モデルの複雑さへの対応

高度で複雑なAIモデル(特に深層学習やLLM)に対して、既存のXAI技術は説明の質が低下しやすいことが課題となっています。モデルの性能を損なわずに複雑性を抑えるモデル設計や、複雑なモデルにも適用できる新たな説明手法が求められています。

- 説明機能を持つAIモデルの構築

学習段階から説明性を組み込んだモデル開発(解釈可能なモデル、ハイブリッドモデル、対話型説明など)が重要とされています。設計上の倫理的・法的配慮も含め、実用的な説明可能モデルの研究が必要とされています。

- モデルの性能と解釈性のトレードオフ解消

モデルの性能と説明性の両立の間にあるトレードオフは大きな課題のひとつとされています。特に時間的制約や複雑なモデルなどでは、高性能かつ高い説明性を両立するための手法や基準の確立が求められており、そのバランスの最適化を解決する手法が必要とされています。

- 評価方法と標準化

XAIの説明の質や有用性を測る評価指標や評価手法の標準化も課題のひとつです。多様なモデル・用途に適した柔軟な評価指標や、目的に応じた最適な評価方法の開発が必要とされています。

- セキュリティ・プライバシーとの両立

説明の提供が情報漏洩や攻撃(モデルインバージョン、敵対的サンプルの生成など)を招く懸念があります。説明性とセキュリティ・プライバシーの間にはトレードオフの関係性があるため、このバランスをとる技術(差分プライバシーなど)の研究が求められています。

- マルチモーダル・多言語・多文化XAI

テキスト、画像、音声など複数のデータタイプや、多言語・多文化に対応した説明手法の開発が急務となっています。特にLLM等のマルチモーダルモデルに対するXAIの標準化と適用範囲が拡大しており、それに対する説明性の提供技術に関する研究が必要とされています。

- リアルタイム性のある説明の実現

既存手法は、自動運転や医療などリアルタイムでの説明の提供が必要な場面に対応することは困難です。そのため、リアルタイム性のある説明を適用可能な効率的で高速なXAI手法の開発が重要とされています。

- 多様なユーザや社会への適応

社会的・文化的背景や利用者の専門性に応じた説明内容の最適化やユーザフィードバックを活用した説明の改善・パーソナライズも今後の課題です。このような課題を解決することは、AIの公平性にもかかわるため、非常に重要であると考えられます。

まとめ

本記事では、XAIについて解説しました。XAIに関する今後の研究では、より複雑なモデル・マルチモーダル対応、高性能と説明性の両立、標準化、セキュリティ・プライバシーとの両立、およびリアルタイム性の実現などが主要な課題であり、ユーザや社会への適応も含めた総合的・学際的な発展が期待されています。このような技術が発展することで、将来、信頼性や公平性の高いAI技術を安全に利活用することができるでしょう。

参考文献

[1] Dwivedi, Rudresh, et al. “Explainable AI (XAI): Core ideas, techniques, and solutions.” ACM Computing Surveys 55.9 (2023): 1-33.

[2] Devireddy, Keerthi. “A Comparative Study of Explainable AI Methods: Model-Agnostic vs. Model-Specific Approaches.” arXiv preprint arXiv:2504.04276 (2025).

[3] Mersha, Melkamu, et al. “Explainable artificial intelligence: A survey of needs, techniques, applications, and future direction.” Neurocomputing (2024): 128111.

[4] Ribeiro, Marco Tulio, Sameer Singh, and Carlos Guestrin. “” Why should I trust you?” Explaining the predictions of any classifier.” Proceedings of the 22nd ACM SIGKDD international conference on knowledge discovery and data mining. 2016.

[5] Lundberg, Scott M., and Su-In Lee. “A unified approach to interpreting model predictions.” Advances in neural information processing systems 30 (2017).

[6] Wachter, Sandra, Brent Mittelstadt, and Chris Russell. “Counterfactual explanations without opening the black box: Automated decisions and the GDPR.” Harv. JL & Tech. 31 (2017): 841.

[7] Simonyan, Karen, Andrea Vedaldi, and Andrew Zisserman. “Deep inside convolutional networks: Visualising image classification models and saliency maps.” arXiv preprint arXiv:1312.6034 (2013).

[8] Bach, Sebastian, et al. “On pixel-wise explanations for non-linear classifier decisions by layer-wise relevance propagation.” PloS one 10.7 (2015): e0130140.

[9] Zhou, Bolei, et al. “Learning deep features for discriminative localization.” Proceedings of the IEEE conference on computer vision and pattern recognition. 2016.

[10] Sundararajan, Mukund, Ankur Taly, and Qiqi Yan. “Axiomatic attribution for deep networks.” International conference on machine learning. PMLR, 2017.

[11] Yeh, Catherine, et al. “Attentionviz: A global view of transformer attention.” IEEE Transactions on Visualization and Computer Graphics 30.1 (2023): 262-272.

[12] Wu, Skyler, et al. “Analyzing chain-of-thought prompting in large language models via gradient-based feature attributions.” arXiv preprint arXiv:2307.13339 (2023).

[13] White, Jules, et al. “A prompt pattern catalog to enhance prompt engineering with chatgpt.” arXiv preprint arXiv:2302.11382 (2023).

[14] Slack, Dylan, et al. “Explaining machine learning models with interactive natural language conversations using TalkToModel.” Nature Machine Intelligence 5.8 (2023): 873-883.

-scaled.png)